對於開發者而言,Cloud Run 已經因其簡單性、快速自動擴展、零擴展能力以及按需計費的定價模式而備受青睞。現在,Cloud Run 又迎來了一個重大的更新:在預覽階段支持 NVIDIA L4 GPU。這一新功能為 AI 推理應用程序開闢了許多新的可能性。

NVIDIA GPU 將如何改變 Cloud Run 的 AI 推理應用

1. 即時推理應用的提升

NVIDIA L4 GPU 的支持意味著開發者可以在 Cloud Run 上進行即時推理,這對於使用輕量級開放模型(如 Google 的 Gemma(2B/7B)模型或 Meta 的 Llama 3(8B)模型)來構建自定義聊天機器人或即時文件摘要的應用程序來說,將是一個巨大的提升。這些 GPU 能夠高效處理突發的用戶流量,從而提供流暢的使用體驗。

2. 定制生成 AI 模型的靈活性

Cloud Run 支持 NVIDIA GPU 使得開發者能夠在自定義生成 AI 模型方面發揮更多創意。例如,您可以使用 GPU 來生成符合公司品牌的圖像,並在不使用時自動縮減資源,從而節省成本。

3. 加速計算密集型服務

NVIDIA L4 GPU 還能顯著提升計算密集型服務的性能,比如按需圖像識別、視頻轉碼和流媒體處理、3D 渲染等。這些計算密集型任務需要大量的計算能力,而 NVIDIA L4 GPU 可以提供所需的加速。

Cloud Run 的優勢:無需基礎設施管理

Cloud Run 作為一個完全托管的平台,允許開發者在 Google 的可擴展基礎設施上直接運行代碼,結合了容器的靈活性和無伺服器的簡單性。這意味著您可以運行前端和後端服務、批處理作業、部署網站和應用程序,還可以處理隊列處理工作負載,而無需管理底層基礎設施。

AI 推理的需求

許多進行 AI 推理的應用程序,尤其是需要即時處理的場景,要求 GPU 加速才能提供良好的用戶體驗。NVIDIA L4 GPU 的加入使得 Cloud Run 能夠在幾秒鐘內完成在線 AI 推理,支持最多 90 億參數的模型如 Llama 3.1(8B)、Mistral(7B)和 Gemma 2(9B),並在應用閒置時自動縮減至零,避免不必要的費用。

行業領袖的好評

NVIDIA 的高級總監 Anne Hecht 表示:“通過支持 NVIDIA L4 Tensor GPU 和 NVIDIA NIM,Cloud Run 提供了一個即時、快速擴展的 AI 推理平台,幫助客戶加速 AI 項目,並更快地將解決方案推向市場——同時管理基礎設施的開銷降到最低。”

早期用戶也對這一更新表示了熱情:

Thomas Menard,L’Oreal 全球美容科技 AI 部門負責人,提到:“Cloud Run 的 GPU 支持對我們的即時推理應用程序來說是一個遊戲改變者。低冷啟動延遲使我們的模型幾乎能即時提供預測,確保我們的生成 AI 應用始終響應迅速。”

Alex Bielski,Chaptr 創新部門總監,表示:“Cloud Run GPU 提供了高度的控制和自定義,並結合了出色的可觀察性工具,完全托管的基礎設施能夠擴展至零,這使得它在使用 GPU 計算方面無疑是最好的選擇。”

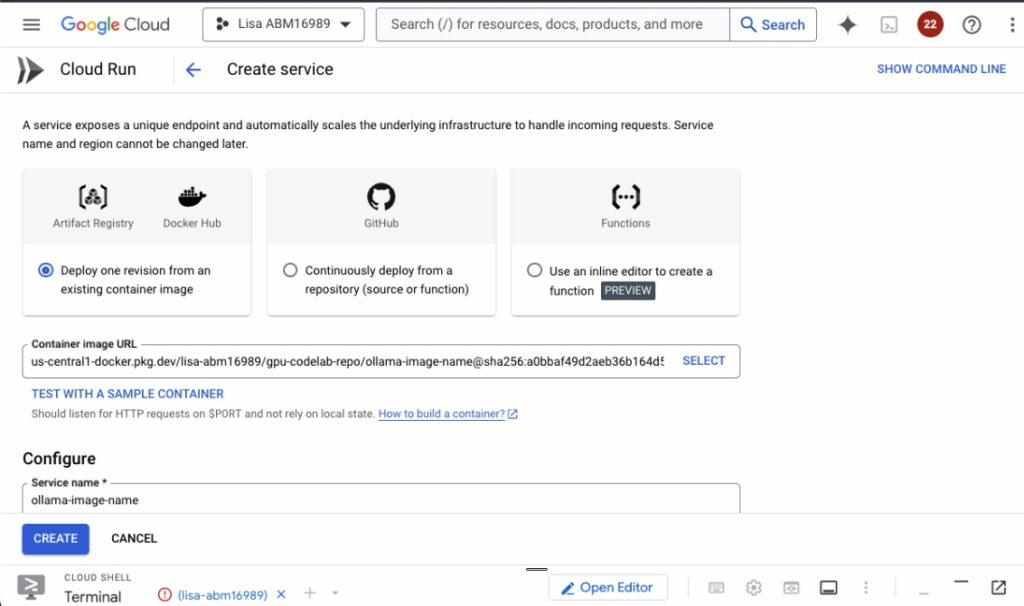

開始使用 NVIDIA GPU 的 Cloud Run

目前,Cloud Run 支持在每個實例上附加一個 NVIDIA L4 GPU,且無需提前預訂。這一功能現已在 us-central1(愛荷華州)提供,預計年底前將擴展到 europe-west4(荷蘭)和 asia-southeast1(新加坡)地區。

如果您對這一新功能感興趣,現在就可以註冊參加預覽計劃,網址為 g.co/cloudrun/gpu。這是探索和利用 Cloud Run 與 NVIDIA GPU 相結合的絕佳機會。

GCP #CloudRun #NVIDIA #AI推理 #生成AI #GPU加速 #即時推理 #雲端計算 #無伺服器 #容器化 #機器學習